Información Técnica

Arquitectura del sistema MareNostrum4 (2017)

MareNostrum es un superordenador basado en procesadores Intel Xeon Platinum, racks de cómputo Lenovo SD530, sistema operativo Linux y una red de interconexión Intel Omni-Path.

A continuación se muestran las características del sistema del clúster de propósito general:

- Rendimiento pico de 11.15 Petaflops

- 384.75 TB de memoria principal

- 3,456 nodos:

- 2x Intel Xeon Platinum 8160 24C a 2.1 GHz

- 216 nodos con 12x32 GB DDR4-2667 DIMMS (8GB/core)

- 3240 nodos con 12x8 GB DDR4-2667 DIMMS (2GB/core)

- Redes de interconexión:

- 100Gb Intel Omni-Path Full-Fat Tree

- 10Gb Ethernet

- Sistema Operativo: SUSE Linux Enterprise Server 12 SP2

Documentación de usuario MareNostrum IV

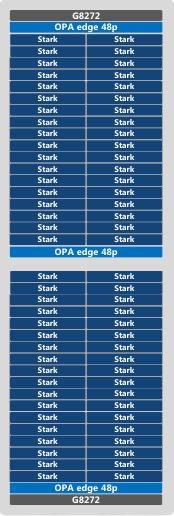

Racks de cómputo

MareNostrum IV tiene 48 racks dedicados a cálculos. Estos racks tienen un total de 165,888 Intel Xeon Platinum cores con una frecuencia de 2.1 GHz y 384.75 TB de memoria total.

En total, cada rack tiene 3,456 cores y 6,912 GB de memoria.

El rendimiento pico por rack es de 226.80 Tflops, y el pico de consumo energético son 33.7 kW.

Cada cómputo de rack Lenovo SD530 está compuesto por:

- 72 Nodos de cómputo Lenovo Stark

- 2 Switches Lenovo G8272

- 3 Edge Switch Intel OPA 48 port

- 4 PDUs de 32A

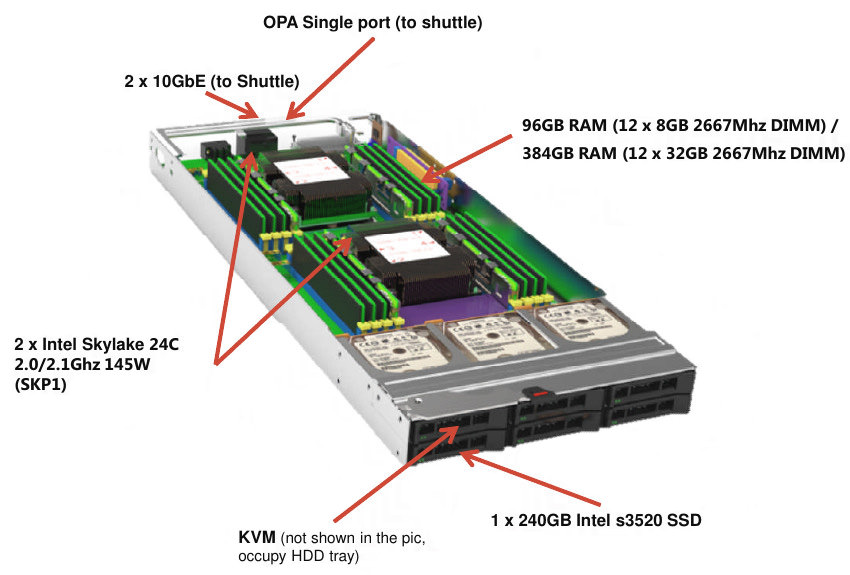

Nodo de cómputo

Los nodos de cómputos están basado en la última generación de la tecnología Intel Xeon Platinum, y ofrecen alto rendimiento, flexibilidad y eficiencia energética. A continuación se muestra la descripción de un nodo:

Rack Intel Omni-Path

Los 3,456 nodos de cómputo están interconectados a través de una red de alta velocidad: Intel Omni-Path (OPA). Los diferentes nodos están conectados vía cables de fibra óptica y switches Intel Omni-Path Director Class.

Seis racks en MareNostrum están dedicados a elementos de la red, los cuales permiten la conexión entre los diferentes nodos gracias a la red OPA.

Las principales características de un switch Omni-Path Director Class son:

- Hasta 786 x 100GbE puertos en 20U (+1U Shelf)

- 12 x hot swap PSUs (N+N)

- Hot swap fan modules

- 2 x Management modules

- 8 x Double spine modules (non-blocking)

- Hasta 24 x 32 port leaf modules (19 occupied – 608 ports)

- Cada leaf module contiene 2 ASICs

- Consumo energético de 9.4kW

Arquitectura de MN4 CTE-POWER

MN4 CTE-POWER es un clúster basado en procesadores IBM Power9, con un sistema operativo Linux y una red de interconexión Infiniband. Su principal característica es la disponibilidad de 4 GPUs para cada nodo, haciéndolo un clúster ideal para aplicaciones aceleradas por GPU.

Su configuración es la siguiente:

- 2 nodos de login y 52 nodos de cómputo, cada uno de ellos con las siguientes características:

- 2 x IBM Power9 8335-GTH @ 2.4GHz (3.0GHz en turbo, 20 núcleos y 4 hilos/núcleo, un total de 160 hilos por nodo)

- 512GB de memoria principal distribuida en 16 dimms x 32GB @ 2666MHz

- 2 x SSD 1.9TB de almacenamiento local

- 2 x 3.2TB NVME

- 4 x GPU NVIDIA V100 (Volta) con 16GB HBM2.

- Single Port Mellanox EDR

- GPFS con un enlace de fibra 10 GBit

El sistema operativo es Red Hat Enterprise Linux Server 7.5 (Maipo).